::ollama

2025年5月10日 上午10:18:06

Ollama 是一个专注于“本地部署”大型语言模型的工具。功效上类似于 docker

1、官网与下载

可以在官网下载对应的版本并安装(有 mac, linux, window):

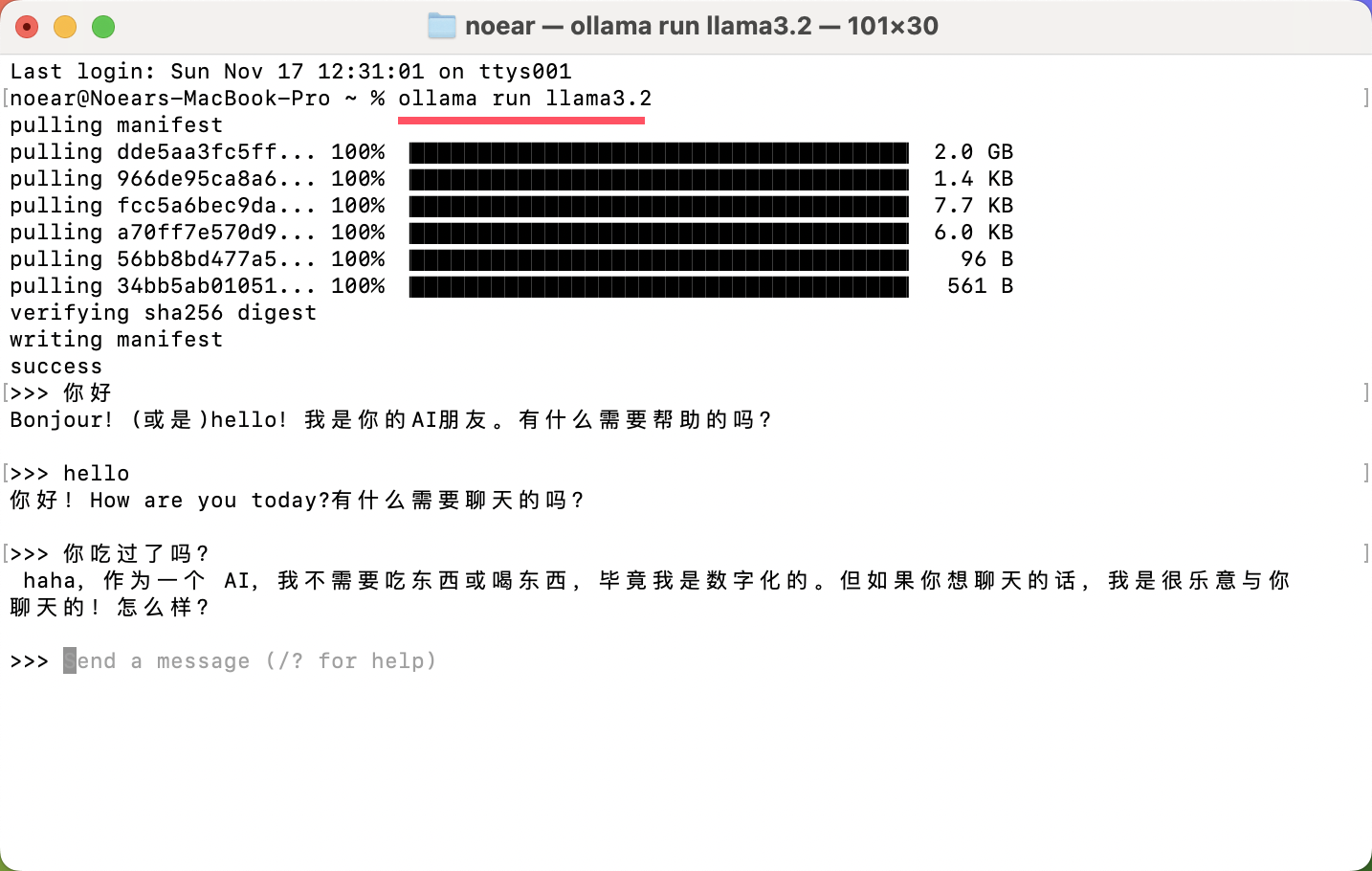

2、运行

命令运行格式:ollama run {model},示例:

# chat-model

ollama run llama3.2 #或者 ollama run deepseek-r1:7b

# embedding-model

ollama run nomic-embed-text:latest #或者 ollama run bge-m3:latest #或者 ollama run shaw/dmeta-embedding-zh:latest

运行后,命令行界面可以做简单的互动:

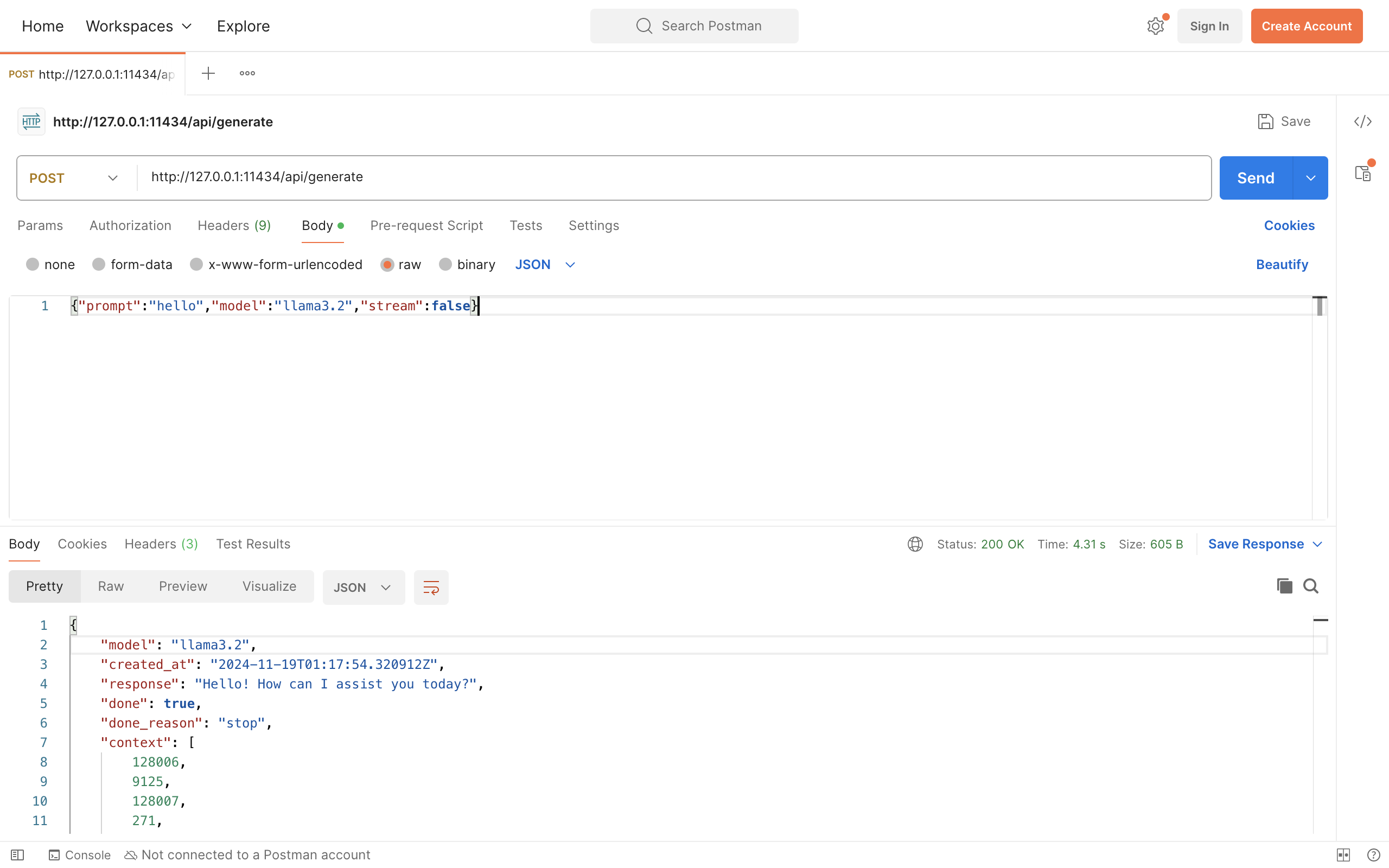

3、调用 web api(http + post + json-body)

运行后也提供 http 服务,默认地址为:http://127.0.0.1:11434/api/chat

- 使用 PostMan 测试

- 使用 HttpUtils 工具调用

return HttpUtils.http("http://127.0.0.1:11434/api/chat")

.bodyOfJson("{\"model\":\"llama3.2\",\"messages\":[{\"role\":\"user\",\"content\":\"hello\"}],\"stream\":true}")

.post();